Comprender cómo nuestra mente organiza y accede a la información espacial ha sido un desafío constante para los científicos. Saber dónde estamos, qué nos rodea y cómo negociar a través de nuestro entorno implica no solo el tema de acceder a los datos y recuerdos almacenados en nuestro cerebro, sino también cómo nuestras neuronas se disparan juntas para realizar cálculos complejos.

Dado que nuestros miles de millones de células cerebrales están conectadas a miles de otras, su estudio es mucho más complejo que el análisis de estructuras individuales. Afortunadamente para los neurocientíficos, que buscan constantemente formas de modelar la función cerebral, la inteligencia artificial puede proporcionar información sobre nuestra propia inteligencia.

Una nueva investigación muestra que los transformadores, uno de los modelos de aprendizaje profundo utilizados en los sistemas automatizados, pueden ayudarnos a comprender mejor cómo nuestras propias redes neuronales llevan a cabo los cálculos y revelar las capacidades del cerebro sin explotar.

Células de cuadrícula: cómo nuestro cerebro mapea ubicaciones

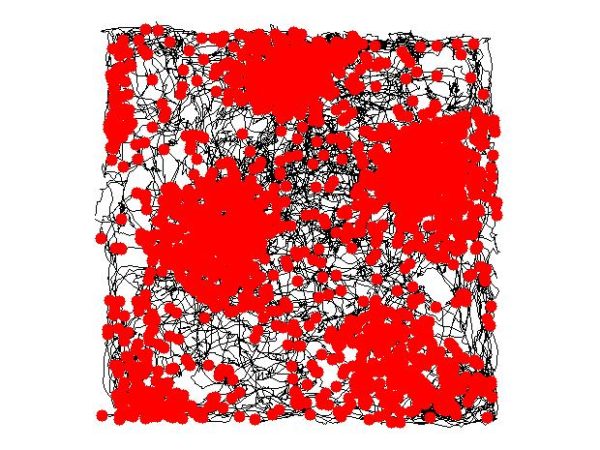

Las celdas de cuadrícula son neuronas que se encargan de procesar y almacenar información sobre la posición de uno en el espacio. A medida que navegamos por un área abierta, estas células cerebrales se disparan a intervalos regulares para integrar información sobre ubicación, distancia y dirección.

Los puntos rojos indican ubicaciones en las que se disparó una celda de rejilla entorrinal en particular.

(Imagen: Khardcastle a través de Wikimedia Creative Commons)

Ubicadas en el hipocampo humano, las celdas de cuadrícula obtienen su nombre del hecho de que conectar los centros de sus campos de disparo forma una cuadrícula triangular, o patrón de panal, que recubre el espacio. Se cree que la disposición simétrica de estos mapas de «activación neuronal» se debe a los esfuerzos del cerebro para crear una representación cognitiva de los espacios percibidos.

Una afortunada similitud entre el hipocampo y los transformadores

Success

You are now signed up for our newsletter

Success

Check your email to complete sign up

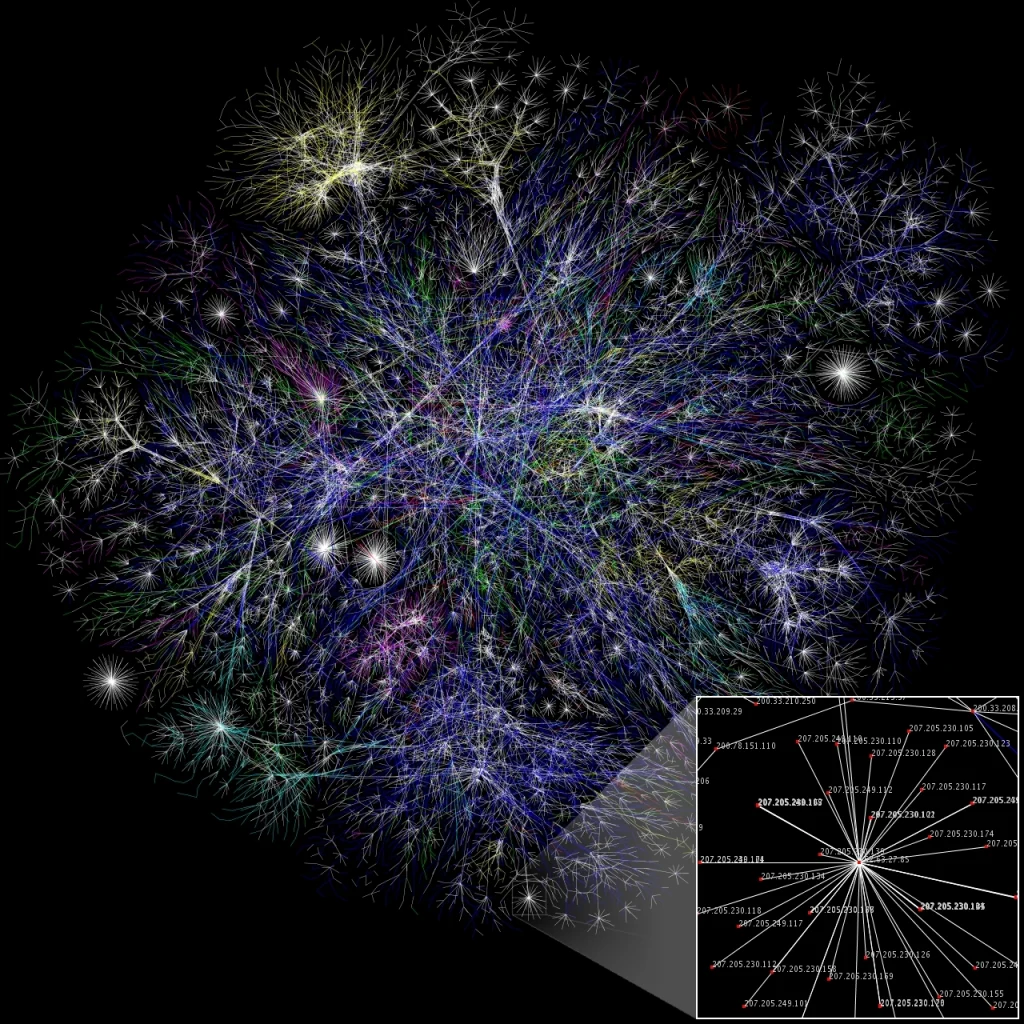

En su búsqueda para optimizar los procesos de aprendizaje automático, los expertos encontraron una similitud práctica en la forma en que los transformadores, un modelo popular de aprendizaje profundo, y el hipocampo, una estructura cerebral clave para la memoria, calculan la información.

A diferencia de otras redes neuronales artificiales, que procesan la información como una secuencia lineal, los transformadores pueden procesar una entrada completa de una sola vez. Al emplear la «autoatención» (un mecanismo que permite que las entradas individuales interactúen entre sí), este modelo pondera la importancia de cada parte de los datos de entrada, lo que hace posible procesar un flujo desordenado de información y adaptarse a entradas que cambian rápidamente- algo que la mayoría de las IA no pueden hacer.

Se componen de unidades conectadas llamadas «neuronas artificiales» que se transmiten señales entre sí en forma de números reales.

(Imagen: El Proyecto Opte vía Wikimedia Creative Commons)

Los científicos creen que al desarrollar y actualizar los transformadores, sería posible comprender mejor el funcionamiento de las redes neuronales artificiales y, lo que es más importante, comprender la complejidad de los cálculos aparentemente sin esfuerzo a partir de datos de la vida real que realiza el cerebro.

Transformadores y su principal aplicación

Los transformadores fueron desarrollados por primera vez en 2017 por un equipo de Google Brain como una nueva forma para que la IA procese el lenguaje. Lo que hizo que este modelo fuera tan innovador fue que, en lugar de procesar una oración como una cadena de palabras, su mecanismo de autoatención podía brindar contexto para cualquier posición de la secuencia de entrada.

En términos prácticos, esto significaba que si se recibía una oración en lenguaje natural, como un dicho o una expresión común, el motor procesaba la oración de una vez en lugar de dar sentido a una palabra a la vez. Esto resultó en la optimización del procesamiento del lenguaje y la reducción de los tiempos de entrenamiento de las máquinas.

Aplicaciones alternativas: Recuperación de memoria

Desde entonces, los transformadores se han empleado en diferentes campos con mucho éxito. Una aplicación digna de mención fue propuesta en 2020 por el científico informático Sepp Hochreiter, quien, junto con su equipo de la Universidad Johannes Kepler de Linz (Austria), usó un transformador para refinar un modelo de recuperación de memoria introducido hace cuarenta años, conocido como red Hopfield.

Una vez que se incorporaron los transformadores a la red de Hopfield, los científicos descubrieron que las conexiones del mecanismo se volvieron más efectivas, permitiéndole almacenar y recuperar más memorias en comparación con el modelo estándar. Luego, el modelo se mejoró aún más al integrar el mecanismo único de autoatención de los transformadores en la propia red de Hopfield.

A través de la inteligencia artificial, los científicos han tratado de modelar y comprender las facultades humanas.

(Imagen: BetacommandBot a través de Wikimedia Creative Commons)

Donde la simetría natural se convierte en regla

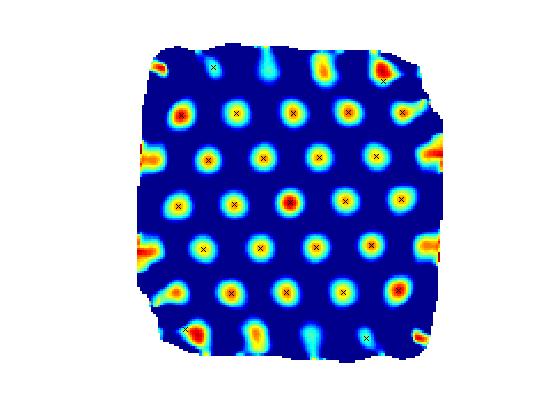

Para ir un paso más allá, los científicos probaron un enfoque diferente a principios de este año. Modificaron el transformador de la red de Hopfield para que, en lugar de tratar los recuerdos como conjuntos de datos lineales, como suele ocurrir con el lenguaje, los codificara como coordenadas en espacios de dimensiones superiores.

Los investigadores quedaron fascinados con los resultados. El patrón mostrado por las coordenadas espaciales era matemáticamente equivalente a los patrones exhibidos por las celdas de la cuadrícula en el hipocampo del cerebro. «Las celdas de la cuadrícula tienen este tipo de estructura regular, hermosa y emocionante, y con patrones llamativos que es poco probable que aparezcan al azar», explicó Caswell Barry, profesor investigador en el University College London.

(Imagen: Torkel Hafting vía Wikimedia Creative Commons)

El descubrimiento insinuó el potencial de la IA para ayudarnos a comprender el cuerpo humano, pero también señaló la asombrosa precisión y las complejidades del cerebro que aún tenemos que comprender. De hecho, incluso los transformadores de mejor rendimiento solo funcionan bien con palabras y oraciones cortas y están lejos de igualar las habilidades del cerebro para realizar tareas a mayor escala, como contar historias.

Si bien existen muchas limitaciones para la IA y graves preocupaciones sobre sus aplicaciones potenciales, su utilidad para ayudarnos a descubrir la profundidad del funcionamiento milagroso del cerebro humano puede ser un paso en la dirección correcta.

LEE TAMBIÉN: La técnica de la medicina china para aliviar el estrés y la ansiedad