Un director de un banco en Emiratos Árabes fue manipulado por unos estafadores que utilizaron un programa de inteligencia artificial que clona voces. La estafa ascendió a 35 millones de dólares, según documentos judiciales.

El 13 de octubre, el Departamento de Justicia de los EE. UU. solicitó una orden ex parte en el Tribunal de Distrito de los Estados Unidos para el Distrito de Columbia que involucra un caso criminal de lavado de dinero en los Emiratos Árabes Unidos que ocurrió en enero de 2020.

La presentación, que es escasa en detalles, establece que el gerente de una sucursal de un banco en Dubai recibió una llamada que parecía ser de un cliente, el director de una empresa no identificada, al mismo tiempo que varios correos electrónicos que parecían originarse en el mismo ejecutivo y abogado de su empresa.

La voz, que reconocieron como la del Director, le dijo al gerente del banco que la compañía estaba a punto de realizar una adquisición comercial y necesitaba mover 35 millones de dólares a varias cuentas en coordinación con su abogado, Martin Zelner, con sede en Estados Unidos.

Resulta que la voz al otro lado de la línea, según el Departamento de Justicia, era una «tecnología de ‘voz profunda’ utilizada para simular la voz del Director».

Success

You are now signed up for our newsletter

Success

Check your email to complete sign up

El dinero se transfirió a cuentas bancarias que residen en varios países «en un esquema complejo que involucra al menos a 17 acusados conocidos y desconocidos». Los investigadores de los Emiratos Árabes Unidos encontraron dos transacciones, por un total de un poco más de 415.000 dólares viajados a través de dos cuentas en el Centennial Bank con sede en EE. UU.

La solicitud es para obligar a Centennial a proporcionar «información y registros bancarios» relacionados con las transacciones.

Un artículo de Forbes del 14 de octubre dijo que ni la Fiscalía Pública de Dubai ni Martin Zelner habían respondido a las preguntas de la prensa sobre el caso.

En 2019, Wall Street Journal (WSJ) informó sobre un caso relacionado en el que se utilizó la IA de voz profunda para estafar 220.000 libras a una empresa energética del Reino Unido, cuando se utilizó la técnica para convencer al director general de una filial del Reino Unido de que el director general alemán de la empresa matriz de su firma estaba en la línea, inflexible para que la transferencia se procesara en una hora.

WSJ dice que el ejecutivo engañado «reconoció el leve acento alemán de su jefe y la melodía de su voz en el teléfono».

El artículo dice que los estafadores se volvieron codiciosos cuando se dispusieron a matar: «Los atacantes responsables de defraudar a la compañía de energía británica llamaron tres veces… Después de que se realizó la transferencia de los $243.000, los piratas informáticos llamaron para decir que la empresa matriz había transferido dinero a reembolsar a la empresa del Reino Unido».

“Luego hicieron una tercera llamada más tarde ese día, nuevamente haciéndose pasar por el CEO, y pidieron un segundo pago. Debido a que la transferencia que reembolsaba los fondos aún no había llegado y la tercera llamada era de un número de teléfono de Austria, el ejecutivo comenzó a sospechar. No hizo el segundo pago».

Una tendencia distorsionadora

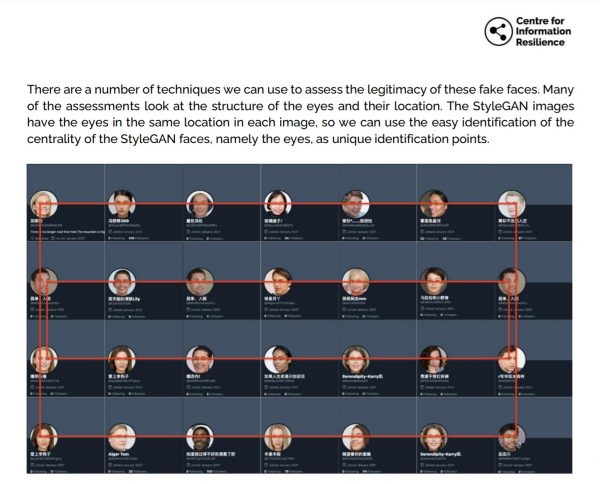

La guerra cognitiva y los ataques profundos y falsos de la IA son cada vez más frecuentes. En agosto, el Centro para la Resiliencia de la Información publicó un informe que mostraba cómo el Partido Comunista chino había utilizado una una red de bots de cuentas falsas de Twitter para difundir influencia tanto en chino como en inglés sobre los temas de la persecución de los musulmanes uigures, la pandemia de la enfermedad del coronavirus 2019 y cuestiones de control de armas y justicia racial en los Estados Unidos.

Los investigadores encontraron que uno de los indicios más frecuentes fue el uso de fotos de perfil creadas por StyleGAN (Generative Adversarial Networks). Uno de los indicios más fuertes de que las fotos fueron generadas por GAN y no de humanos reales es que los ojos de cada imagen siempre estaban en el mismo eje horizontal, un hecho que quedó dolorosamente claro ya que el informe respaldaba su tesis.

En marzo, la cuenta de TikTok DeepTomCruise? publicó tres videos utilizando tecnología de falsificación profunda (deepfake) generada por inteligencia artificial que aparecían para mostrar a la estrella de Hollywood balanceando un palo de golf, haciendo un truco de magia o hablando de conocer a Mikhail Gorbachev.

A simple vista, los clips fueron muy convincentes. Sus únicos indicios de falta de autenticidad se encontraron en un análisis cuidadoso cuando el video se ralentizó, mostrando que las gafas de sol falsas desaparecieron por unos pocos fotogramas después de ser movidas frente a la cabeza.

Guerra cognitiva

Un informe de noviembre de 2020 de Information Hub titulado Cognitive Warfare (Guerra cognitiva), que se describe a sí mismo como un estudio patrocinado por Allied Command Transformation, habla sobre cómo la naturaleza de la técnica erosiona la confianza del público, «La ingeniería social siempre comienza con una inmersión profunda en el entorno humano del objetivo. El objetivo es comprender la psicología de las personas objetivo».

El informe continúa: “Esta fase es más importante que cualquier otra, ya que permite no solo apuntar con precisión a las personas adecuadas, sino también anticipar reacciones y desarrollar empatía. Comprender el entorno humano es la clave para generar la confianza que, en última instancia, conducirá a los resultados deseados».

“La guerra cognitiva persigue el objetivo de minar la confianza (confianza pública en los procesos electorales, confianza en instituciones, aliados, políticos…) por lo que el individuo se convierte en el arma, mientras que el objetivo no es atacar lo que los individuos piensan sino su forma de pensar”.

“Tiene el potencial de desentrañar todo el contrato social que sustenta a las sociedades”, afirma el autor.